La sfida della tecnologia tra Stati Uniti ed Europa

C’è una profonda diversità nel modo in cui Stati Uniti ed Europa guardano allo sviluppo tecnologico: una diversità che deriva dalle specifiche esigenze politiche e militari degli Stati Uniti, ma anche da differenze culturali e sociologiche. Molto ha contribuito, soprattutto a partire dagli anni Novanta, anche un diverso atteggiamento delle autorità antitrust nei confronti delle concentrazioni e della proprietà intellettuale. Un fattore importante è rappresentato dal peso che le spese militari e di intelligence hanno nel bilancio pubblico americano rispetto a quello dei paesi europei.

INDUSTRIA E MERCANTILISMO. Al netto di questo, però, la differenza nasce soprattutto dal modo in cui gli americani affrontano i temi dello sviluppo. Gli Stati Uniti non credono a una politica industriale finalizzata a orientare le scelte dell’industria: credono invece nella forza del mercato, senza rinunciare a sostenere i vincitori per renderli ancora più forti. È un mercantilismo sottile e intelligente, perché è evidente che un sistema industriale forte è un elemento indispensabile per consolidare il primato geopolitico degli Stati Uniti.

L’Europa, viceversa, preferisce giocare un ruolo attivo nell’orientare le scelte dell’industria e soprattutto non vede di buon occhio l’emergere di vincitori che possano creare delle posizioni di monopolio in specifici settori. In cima alle preoccupazioni dell’Europa non c’è la supremazia geopolitica ma il benessere dei consumatori e la necessità di assicurare un mercato omogeneo e competitivo. Per questo in Europa si tendono a privilegiare le soluzioni che garantiscono l’interoperabilità e la standardizzazione. In questo modo si garantisce la pluralità degli attori e il fatto che i benefici vengano rapidamente trasmessi ai consumatori in termini di costi più bassi e di più ampia diffusione sul mercato. Al contrario, negli Stati Uniti la competizione tra tecnologie alternative è finalizzata a far sì che il vincitore abbia il dominio del mercato.

Non è possibile stabilire una preferenza tra questi due modelli, che rispondono entrambi a caratteristiche specifiche delle società che li hanno espressi: una società più competitiva e polarizzata quella americana, una società più egualitaria e attenta ai problemi sociali quella europea. È chiaro però che il modello europeo, più debole nella competizione internazionale proprio per le regole che si è dato e per i valori a cui si ispira, esige di essere difeso con strumenti adeguati.

IL CASO DELLA TELEFONIA MOBILE. Un esempio importante di questa diversa filosofia della posizione americana e di quella europea lo troviamo nella storia dello sviluppo delle tecnologie fondamentali della rivoluzione dell’ICT, a partire da quella delle telecomunicazioni mobili. L’idea originale venne concepita negli Stati Uniti all’interno dei Bell Labs da Donald Ring nel 1947, e sempre all’interno dei Bell Labs l’idea divenne un progetto industriale con il contributo di Joel Engel, Richard Frenkiel e Amos Joel all’inizio degli anni Settanta. Ma per quanto brillante e innovativo fosse il progetto, la diffusione del servizio rimase per molti anni limitata.

L’impulso per la diffusione di massa della tecnologia venne dall’Europa, dove la decisione di sviluppare le telecomunicazioni mobili fu una deliberata scelta politica che portò nel 1982 i responsabili dei ministeri delle poste e telecomunicazioni dei diversi paesi a definire assieme uno standard comune rappresentato dal GSM. Lo standard era basato sulla tecnologia TDMA che consentiva a diversi utilizzatori di condividere lo stesso canale di frequenza dividendo il segnale in diversi slot temporali. Grazie a questa scelta di politica industriale la tecnologia ebbe una diffusione di massa.

La spinta europea venne però meno quando, all’inizio degli anni Duemila, ci fu il passaggio dalla seconda generazione di tipo analogico alla terza generazione, la digitale. Senza la spinta propulsiva dell’Europa che aveva portato ad adottare il GSM, la decisione degli organismi di standardizzazione fu quella di scegliere una tecnologia sviluppata da DOCOMO in Giappone e utilizzata anche negli Stati Uniti: il w_cdma. Qui, un’importante società tecnologica – la Qualcomm – aveva sviluppato un “chipset” che offriva una soluzione a costi contenuti per lo sviluppo di terminali mobili di standard cdma. Quella soluzione divenne rapidamente uno standard mondiale, dando a Qualcomm il monopolio di fatto di una componente fondamentale dello sviluppo dei cellulari di terza generazione. La società ancora manteneva questa posizione nel 2015, quando la Commissione europea iniziò una indagine sulle pratiche anticoncorrenziali di Qualcomm finalizzate a escludere dal mercato un concorrente: la Icera. Di lì in avanti le indagini della Commissione accertarono ulteriori violazioni della normativa antitrust che comportarono nei confronti di Qualcomm sanzioni per oltre 1,2 miliardi, l’ultima nel gennaio 2021 per 242 milioni di euro.

IL 5G E IL 6G. A dimostrazione dello scarso interesse americano per una politica industriale attiva vale la pena di citare anche la scelta di abbandonare nel tempo il presidio dell’industria della infrastruttura di telecomunicazioni. Il campione americano in questo settore era Lucent, una società derivata da AT&T Technologies che era stata creata nel 1993 nel quadro della riorganizzazione del sistema AT&T. Nel tempo Lucent non si è dimostrata in grado di competere, finendo prima assorbita dalla società francese di infrastrutture Alcatel e poi in una riorganizzazione complessiva dell’industria occidentale che ha visto la combinazione tra Lucent, Alcatel e la parte infrastrutturale di Nokia. Il vuoto lasciato dall’industria occidentale di infrastrutture di telecomunicazioni ha lasciato spazio di crescita ai cinesi che con Huawei e ZTE, grazie alle dimensioni del mercato interno e al supporto dello Stato, sono diventati i leader mondiali del settore.

Solo di fronte al rischio geopolitico rappresentato dal dominio di Huawei gli americani sono corsi ai ripari, contrastandone la presenza sui mercati dei paesi alleati e promuovendo assieme all’Europa uno standard aperto – l’Open RAN – che consentirà ai paesi occidentali di recuperare una capacità di sviluppo autonomo.

Lo sviluppo delle reti di nuova generazione, il 5G e il 6G, potrebbe restituire all’Europa una capacità di leadership nel settore. Contrariamente alle generazioni precedenti, le nuove generazioni sono meno orientate al consumatore e molto più orientate a specifiche esigenze industriali, dove la struttura e gli interessi europei sono più forti. E proprio in Europa è stato impresso un notevole sviluppo alla possibilità di segmentare e specializzare le reti 5G per finalità di tipo industriale. Siemens, per esempio, si sta muovendo su questa linea e a fine decennio prevede di avere un milione di reti private 5G che gestiranno un’enorme quantità di apparati collegati all’Internet of Things (IOT). Anche per queste ragioni la Commissione europea sta promuovendo attivamente lo sviluppo del 5G all’interno del programma Next Generation EU.

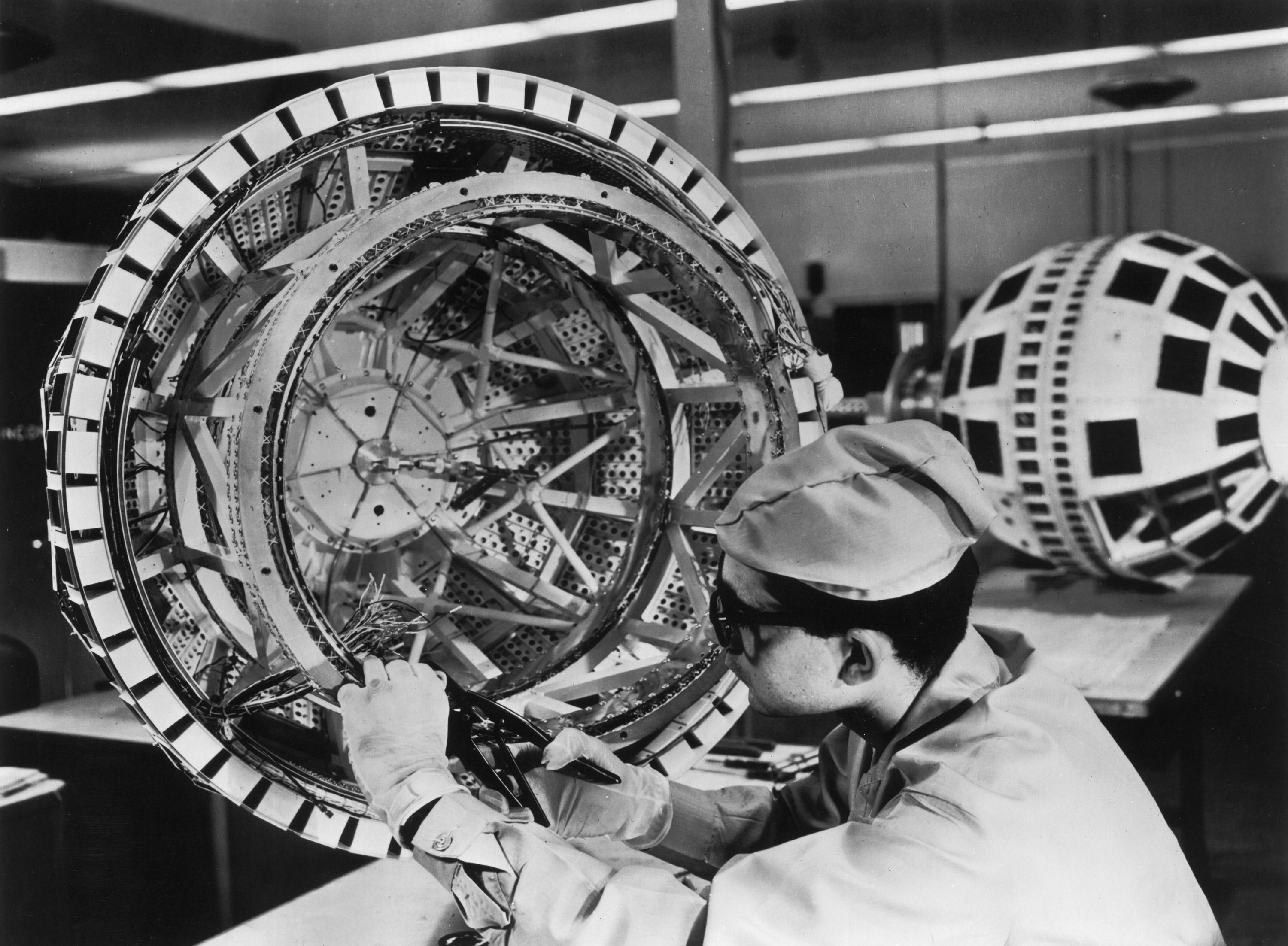

L’IMPULSO DEI BELL LABS. La seconda fondamentale componente della rivoluzione tecnologica è rappresentata dai microchip. Lo sviluppo di questa tecnologia offre uno spaccato ancora più interessante su come si è evoluta la filosofia americana in tema di antitrust e di politica industriale. La componente fondamentale – cioè il transistor – è stata inventata sempre all’interno dei Bell Labs nel 1947 da John Bardeen, Walter Brattain e William Shockley. I Bell Labs, una struttura di ricerca e sviluppo che beneficiava della collocazione all’interno di una società che aveva il monopolio del sistema di telecomunicazioni, godevano anche di un forte supporto del ministero della Difesa perché avevano sviluppato il radar durante la guerra. L’importanza dei Bell Labs per lo sviluppo tecnologico americano è testimoniata da poche cifre: tra il 1940 e il 1970 i Labs hanno registrato circa 540 brevetti all’anno, una percentuale significativa di tutta la produzione di brevetti negli Stati Uniti. Oltre alle telecomunicazioni mobili e al transistor, si devono ai Bell Labs, tra gli altri, lo sviluppo del fotovoltaico (1954), il laser (1957) e il sistema operativo Unix (1969).

Nonostante l’importanza strategica del sistema AT&T, nel 1949 il governo americano avviò una azione antitrust nei suoi confronti con l’obiettivo di separare le attività industriali di Western Electric e dei Bell Labs dai servizi di telecomunicazione di AT&T. Dopo una lunga istruttoria il caso si chiuse nel 1956 con l’imposizione di alcuni rimedi, tra i quali l’obbligo imposto a Bell di garantire, senza costi per chiunque ne facesse richiesta, la licenza di tutti i brevetti sviluppati prima del decreto antitrust, mentre quelli sviluppati dopo il decreto dovevano essere offerti a condizioni ragionevoli.

Per aderire alle richieste del regolatore Bell decise di offrire la licenza del transistor con contratti standard non discriminatori, ma soprattutto decise di promuovere la tecnologia organizzando conferenze per spiegarne il potenziale. Nell’aprile 1952 oltre 100 rappresentanti di 40 società si riunirono per una conferenza dedicata ai transistor della durata di 9 giorni. Alla fine della conferenza 30 società decisero di acquisire la licenza per una cifra di 25000 dollari. Tra queste sia giganti come GE e RCA sia società molto più piccole come Texas Instruments e Sony, con il risultato di dare vita probabilmente alla più importante disseminazione di tecnologia della storia americana.

ANTITRUST E ANTI-ANTITRUST. Il ruolo dell’antitrust fu importante anche in un altro momento cruciale della diffusione dell’innovazione tecnologica: la causa antitrust contro l’IBM che portò alla separazione tra hardware e software creando due filoni industriali completamente indipendenti. La decisione di dividere AT&T e di impedirle di entrare nel mercato dell’elettronica sussidiando lo sviluppo del settore con i profitti del monopolio della comunicazione, aveva dato una spinta soprattutto a IBM. Quest’ultima peraltro – anche in seguito alla causa antitrust per l’abuso di posizione dominante nel mercato dei tabulatori conclusasi nel 1956 – aveva cercato proprio nella nascente industria dei computer l’occasione per un rilancio. Il successo fu tale che nel 1969 IBM si trovò nuovamente a fronteggiare una causa antitrust per abuso di posizione dominante nel mercato dei computer.

Questa volta la principale contestazione era che la politica commerciale della società non consentiva di valorizzare separatamente hardware, software e servizi, limitando in questo modo gli spazi di concorrenza. In pratica, si contestavano gli ostacoli posti allo sviluppo dei produttori indipendenti di software perché IBM non valorizzava il software in maniera trasparente.

Poco dopo l’avvio dell’azione antitrust, sempre nel 1969, IBM decise comunque di offrire separatamente hardware, software e servizi: una decisione che secondo la società era già allo studio, ma che è difficile non far risalire all’avvio dell’azione antitrust. Negli anni Cinquanta e Sessanta si era dunque realizzato un circuito virtuoso nel quale la combinazione tra il dinamismo tecnologico delle società americane e l’azione delle autorità antitrust aveva consentito una straordinaria diffusione del potenziale di innovazione, e non solo negli Stati Uniti.

Questa situazione cambiò nel corso degli anni Settanta e ancora di più dopo l’elezione di Reagan alla presidenza degli Stati Uniti. Sotto l’influenza della scuola di Chicago l’approccio nei confronti dell’antitrust ebbe una radicale inversione di rotta. La base intellettuale della svolta fu un libro di Robert Bork del 1978, The antitrust paradox, nel quale si argomentava a favore dei benefici in termini di efficienza del monopolio. Secondo Bork, nell’approvare lo Sherman Act il Congresso aveva come solo obiettivo quello di migliorare il benessere del consumatore e non di mettere in discussione le posizioni di monopolio. Le tesi di Bork ebbero largo seguito nel sistema giudiziario arrivando fino alla Corte suprema, dove i giudici nominati da Nixon e Ford rovesciarono una consolidata giurisprudenza della Corte che risaliva all’inizio del secolo, rendendo più difficili gli interventi antitrust. Bork stesso venne nominato da Nixon Solicitor General al dipartimento di Giustizia.

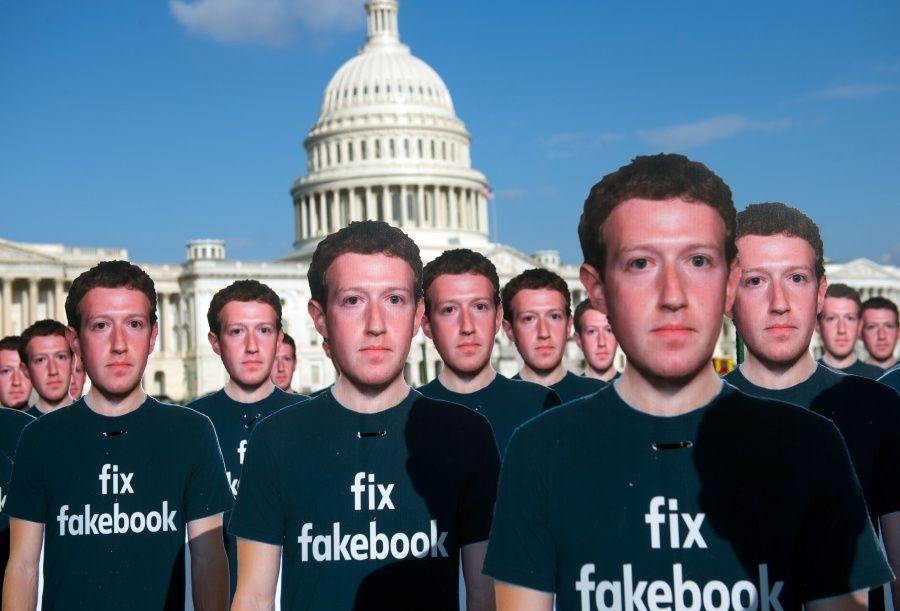

Con Clinton, sorprendentemente, l’atteggiamento nei confronti dei processi di concentrazione industriale divenne ancora più favorevole e vennero create le condizioni normative che avrebbero consentito di realizzare lo straordinario processo di consolidamento di cui hanno beneficiato i nuovi player di internet. Contrariamente a quanto era avvenuto nel passato, ai GAFA – Google, Amazon, Facebook e Apple – è stato consentito di costruire una posizione dominante in ciascuno dei settori di attività, ma non solo. È stato consentito loro di fare acquisizioni che hanno progressivamente impedito che si sviluppassero dei concorrenti nei settori che ciascuno di essi presidiava, e di invadere mercati adiacenti grazie alle risorse finanziarie generate dalla posizione dominante di mercato.

Solo adesso si è sviluppata negli Stati Uniti una maggiore consapevolezza dei problemi che questa incredibile concentrazione di mercato e di risorse finanziarie sta creando e si sono avviate al Congresso iniziative per creare condizioni più aperte di mercato.

L’APPROCCIO EUROPEO ALLA NUOVA TECNOLOGIA DIGITALE. L’Europa si è mossa in ritardo e per lungo tempo con grande timidezza. La mancanza di consapevolezza dei rischi di quello che stava avvenendo negli Stati Uniti aveva portato nel 2000 alla firma dell’International Safe Harbor Privacy Principles, con il quale Stati Uniti e Unione Europea regolavano le modalità attraverso cui le società americane esportano dati personali di cittadini europei. Un accordo che non tutelava in alcun modo i cittadini europei e che venne superato nel 2016 dalla firma del “privacy shield”, accordo comunque anch’esso dichiarato invalido dalla Corte di Giustizia dell’UE nel 2020.

A partire dal tema della privacy – che rientra in Europa tra i diritti fondamentali di cittadinanza mentre negli Stati Uniti è semplicemente garantito come tutela dei consumatori – la consapevolezza si è estesa anche ad altri aspetti: da quello della fiscalità, all’abuso di posizione dominante e altre pratiche monopolistiche. Ma l’Europa non ha la forza di imporre una struttura di mercato diversa se gli Stati Uniti non si muovono nella stessa direzione. È quello che sta avvenendo ora su iniziativa del Congresso americano.

Più recentemente l’Europa si è mossa affrontando la questione del rapporto coi GAFA nella sua globalità e secondo i medesimi criteri che avevano ispirato lo sviluppo del GSM quasi quarant’anni fa. Si tratta del progetto Gaia X che prevede la definizione dei requisiti tecnici minimi e dei servizi necessari a operare un ecosistema che consenta uno sviluppo diffuso dell’utilizzo di infrastrutture digitali. Gli aspetti più importanti di questo concetto sono l’implementazione di meccanismi condivisi di accertamento dell’identità e di garanzia della sicurezza. Un aspetto di grande rilievo per il futuro dell’uso di internet, in cui queste caratteristiche non sono presenti in modo nativo. Il progetto prevede anche l’integrazione degli standard esistenti in modo da garantire l’interoperabilità e la portabilità attraverso le diverse infrastrutture delle applicazioni e dei dati; e infine, lo sviluppo di software open source e di standard che supportino gli operatori nell’accedere a una infrastruttura sicura, federativa e interoperabile.

Coerentemente con le esigenze dell’Europa, il progetto Gaia X dedica una assoluta priorità ai temi dell’industria 4.0. Gli aspetti affrontati sono molteplici e vanno dalla manifattura intelligente allo sviluppo di piattaforme IOT, alla manutenzione predittiva. L’Europa correttamente punta a dotare la manifattura avanzata tradizionale, sulla quale conserva una posizione di assoluto vantaggio, delle più avanzate funzionalità garantite dalla nuova tecnologia digitale. La combinazione tra un sistema più aperto sul fronte della tecnologia, dove vengano bloccati gli abusi che ne hanno caratterizzato finora lo sviluppo, e il rafforzamento tecnologico dell’industria di cui potrà beneficiare anche la piccola e media industria sarà certamente in grado di consentire all’Europa di affrontare la sfida di un contesto globalizzato da una posizione di maggiore forza.